2018年11月30日金曜日

2018年11月21日水曜日

コンペ進捗状況

コンペ応募の要件に対しての見直しをしているところです。

*さらっとサーモグラフィー開発を振り返ってみます。

長くなるので今回はここまで…

作業の進捗は大体のデザインの機能については決まりカラーパレットの追加と温度表示周辺の拡大表示とポイントクラウドを使った温度差の立体表示。

会社のロゴも挿入。(右下)

右がSSH接続したPI3のターミナル。左がXavierターミナルで、2つともXavierで動かします。

PI3はmake run で動かしますが、開始時にXavierのIPを入力するようにする予定です。実行方法はこれだけ。

PI3にディスプレイをつけなくても動きます。(接続してれば白黒画像が表示されます)

Xavierの画像は左にGUIボタンを表示してます。基本設定はiPhone版と同様の設定ができるようにする予定です。

カラー変更はあったほうがいいと思うのでつけてます(16種類)。3D画像も別々にカラー変更できるように考えてます。

Xavier——>カーソル座標、カラーレンジ数値、ダイナミックレンジ数値、強制リセットデータを送り

PI3————>LEPTON白黒画像、カーソル周囲9x9ドットの温度81個、最低最高温度、カーソル部分の温度

を相互に送ってます。iPhone使用の時とは違って、命令の遅延がほとんどないので、相互のi2Cを含めたGPIO制御も自在に実行できると思います。

gifなので詳細画像は下記で確認できます。

サーモセンサーとPIのデータ転送の問題があり、30MHz以上の通信(CLK)なのでノイズの影響を減らす為に配線を直線にして最短にしています。

配線より基板の方が影響が少ない様なので基板試作。

こんな感じ。一発で決まらないので初回ロットが来たら調整。

2年前当初Lepton 1(80x60)はこんな感じで補間することで輪郭が滑らか。

このブログの結果が私たちの開発の始まり。

ここからが大変でした。Leption 3(160x120)は4倍の解像度で尚且つ80x60のデータを4分割で送ってくるのでそれぞれのデータの先頭を見つけて一画面に再構成する複雑な処理をしなくてはいけない為、ESP8266のプログラムメモリーの大半を消費してバッファーが溢れてエラーしまくりでプログラムを一から見直してメモリの消費量も減らすことも必要で3ヶ月以上先の見えないテストをひたすら繰り返しました。

繋がるまでも、繋がってからも苦労の連続

試作の数々、これでも一部で20個の試作基板を作って手半田でテストを繰り返しました。

FLIRの英文SDKと格闘、レシーバー側のMCUのメモリ問題、SDK自体の限られた情報やSPI通信のスピード(600MHz以上)がとても早く基板パターンも変更に変更を重ねて数ヶ月掛かる。その間はソフトは数百回コンパイルとデバックを繰り返しして接続テスト。

iPhoneのデザリング機能を使って無線LANを使って可視化。当初はXcode試作だけ。

その後は録画機能、カラーパレット、コントラスト調整等の機能を追加してApp storeでアプリを公開

昨年のMAKER FAIRE TOKYO 2017で既にJetson TX2を使ってAI(機械学習)を展示。

2017年6月公開

つまりこのシステムの開発は二人で既に1年半以上費やしている。

2018年11月18日日曜日

画像認識の追加とアノテーションの検証が難しい…

流石にコンテストに出る為の準備期間が短く当初の予定をこなすのに手一杯です。

簡単にモデルを追加するのは難しい。

なぜか?

CNN(畳み込みニューラルネットワーク)の仕組みにあります。

動画から画像を分割して学習データを作ってモデルを作るのはそう簡単ではありません。

なぜか、コンピュータがそう都合よく学習してくれない…

モデルを作る為に画像データは最低でも5000枚は必要でAさんの写真を色々な角度や背景や条件で撮ってその画像のAさんを四角で囲ってテキストデータにその座標と”Aさん”と2つ1組のデータセットを作ってフレームワークで学習させます。

その計算根拠は

簡単にモデルを追加するのは難しい。

なぜか?

CNN(畳み込みニューラルネットワーク)の仕組みにあります。

動画から画像を分割して学習データを作ってモデルを作るのはそう簡単ではありません。

なぜか、コンピュータがそう都合よく学習してくれない…

モデルを作る為に画像データは最低でも5000枚は必要でAさんの写真を色々な角度や背景や条件で撮ってその画像のAさんを四角で囲ってテキストデータにその座標と”Aさん”と2つ1組のデータセットを作ってフレームワークで学習させます。

その計算根拠は

や

そのイメージは度々お見せしている下記神経ネットワークを模したものです。

入力層(l-1層)から隠れ層(l層)を経て出力層(l+1層)を行ったり来たりしながら

機械学習します。

もう少し具体的にはそれぞれのピクセル単位で行列演算をします。YOLOの場合32の倍数で416x416でこれに画像の濃淡で仮に8ビットで256階調で1枚あたり44,302,336回(=416x416x256)の行列演算x5000枚(2.21512e11回)22京回?をGPUで処理してモデルを作ります。その後学習が正しいか検証します。

学習中にパラメーターで大体の数値が良いかは出ますが、モデルを使って実際にテストして推論の確率を出さないと分からないのが現状です。

行列演算

じゃあ機械は何をみてるのかというとその特徴量を計算しています。

人間に分かりやすく可視化すると、

その可視化されたフィルタリングはというと

分かる人が見ないと分からない…

これで機械が正しく推論を行なっているかの検証は今の私には無理です。

私場合は学習データを撮り直してやり直しし続けて認識率を上げるしか出来ないです。

それで率が上がるかも定かではありません。コンテストの期日に間に合うかも分からない状況です。

この学習データを作る事をアノテーションと言います。

これを専門にする業者があるくらいです。

データサイエンティストと呼ばれる研究者は出てきた計算結果や上記の表を検証する方法を知っているでしょうしそれにあわせて修正するでしょうが、今の私のレベルでは難しいです。因みにこれを理解して作業を出来る人は現在世界中で争奪戦です。年収1000万以上で引く手あまただそうです。それくらい出来る人が不足しています。

作業自体は時間があればやってみようとは思います。数日では到底無理でかなりの時間掛かりっきりになります。

今回は画像認識の機械学習ですが、それ以外の機械学習も同じ様な事をしています。

論文(和訳)自体見ていますが理解出来ていません。

このリンクは元の論文の和訳をされています。

もとの論文です。これは画像認識の可視化についてだけです。CNNの仕組みはまた別です。

なんとかしようと思いましたが、この週末煮詰まって何もする気になりませんでした。

これだけ短期間にこれだけのものを理解し実践するのは難しいです。

これをみてそれを理解して頂けるとありがたいです。

2018年11月17日土曜日

社会に役立つものやサービス(兼コンテストの草案)

今後AIや機械学習と呼ばれるサービスの需要は様々な産業で増え続け、既存のサービスとの融合は益々重要になるでしょう。難解な技術を意識すること無く利用されるような社会になっていくのは時間の問題と思われます。

昨今この分野はインターネットが普及した時以来の大きな変革と理解されています。

過去、インターネット革命の際はパソコン(情報処理能力)やコンピューター通信(ネットワーク)の普及は便利な情報検索やメールサービスの需要と合間って爆発的に進みました。

仕組み自体の理解はそれほど難しくものではなくパソコンとインターネットを理解出来なくても機器を購入する事でサービスを便利に利用出来ました。

AIや機械学習とは、ハード・ソフトが飛躍的に進化した現在、人間の神経学的な学習過程をコンピューターで処理し推論、判定をする事で利用出来るサービスです。その仕組みは最先端の論文で成り立っており一般に理解され難いものです。

日本では人工知能と呼ばれ「万能な物」、「人間の職種が消滅する」、「コンピューターが自己学習して人間を支配する」等で誤解されやすいように思います(AIセミナーに参加している会社でも真にシステムを理解している会社は少ない様です。)

当社でこの技術を利用する為に書籍、インターネットの情報やセミナーを通じて知り得た情報で実現可能なサービス、出来ないサービスか現時点では難しいサービスはある程度理解できました。さらに、実現可能でも費用対効果を良く考えないといけない事も見えて来ました。それなりに時間を掛けて勉強していますが、進化のスピードは非常に早くより難解になっています。(時間の問題ですが、効率良く基礎技術の習得が必須、それでもでかなりの時間がを要し、参考書等は論文がベース。統計学や確率論の基礎理解や行列演算等の数学の知識が無ければ理解は難しいレベルの資料を読み進めています。)ここは避けて通れず、参考書で要約した情報を理解する事は実質無理で、これらを情報を元に、学習と実践を繰り返しながら根気よく進めている状況です。

*AIと言う単語は誤解されやすく極力その呼び方を避けています。今は機械学習(MACHINE LEARNING)を使う様にしています。諸刃の剣で一般の人には理解されやすい反面、誤解も生じています。

俗にAIサービスを提供する会社にだいたい300−500万円払えば大体のサービスは何とか形になりますが本質の技術の理解が無ければそれ以上の発展や応用は不可能。そもそも機械学習は再学習を繰り返して推論の精度を上げてサービスを向上するものなので、継続した支出が必要で(ここを理解していない会社は多いです)、結局継続が難しくなり、自社でシステムを理解しながら進めていかないと費用対効果が出ない状況。つまり開発初期は、そのサービスを提供会社に依頼したとしても、継続して改善する部分は極力自社運用が必要だということです。

上場企業であれば予算がありある程度の費用対効果は見込めますがそれ以外の中小の会社にはかなり難しい金額だと思います。

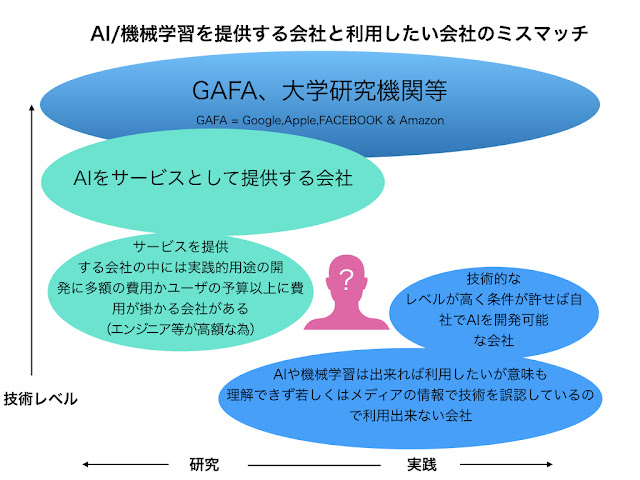

弊社も含めて困っている会社のイメージはこんな感じ

ザクっと足らない技術を習得する為の本だけでもこの量

これらの情報を読み進めて行く中で技術は早いスピードで進化しておりある程度発表されたばかりの論文も理解する必要があります。理解はかなり専門的な知識が必要。

つまり今から始めるのは赤い部分。その後どちらの方向に進むか予算を考えながら進みます。

セミナー等であたりを見渡すと同じ様な会社は多く、これから実践するものを共有できれば社会の役に立つのではないかと考えました。

なにで実現するかと言うと、今最新のエッジとして有名なnvidia Jetson Xavier(写真右側)やTX2(機械学習用エッジとしては企画的低コストー写真左側)

開発環境は全てオープンソースでメーカーからのSDKも豊富。

とYOLOと言うフレームワークここ2、3年流行って来ている新しいフレームワーク

(YOLO = You Only Look Once <- You only live once = 人生一度限りをもじってます)

それぞれトヨタの様な大企業からスタートアップと呼ばれるAI関連の会社で幅広く使われているハードとソフトで柔軟性があり色々な応用が可能。

ここまではどの会社でも出来るので、ここに電機機器を扱う会社ならではの技術であるサーモグラフィーの技術を使って機械学習と推論を実践します。

ハードウェアは一般に購入可能で今回このシステムを共有する個々の会社で購入して頂きます。ハードウェア総額で10万円〜30万円程度(nvidiaの開発者登録をすれば〜20万円で済みます。)

インストールを出来ない場合はインストールのサポート費として10万円〜15万円申し受けます。

Do it yourself !なのでこれらのハード以外に費用は殆ど掛かりません。ハード自体の需要は高く使えなくてもオークションで今なら半額で簡単に処分できる上それ以外のROS(ロボット用の基本ソフトもインストールも可能)で損をする事は殆どありません。

これとは別にnvidia GPUを搭載したLinuxパソコンがホストPCとしてXavierやTX2にソフトウェアをインストールする為に用意する必要があります。既存のパソコンにnvidiaのグラフィックカードを追加して無償のUbuntuを別パーテションにインストールする事で新たにPCを購入する必要はありません。但しトラブルが出た際の事を考えると十数万円のパソコンを揃えた方が無難ではあります。

また今回独自に使っているサーモグラフィーの技術は第6の感覚として知られている技術で高コストな技術を安価に実現出来るLepton開発環境を利用して現在使用しているソフトとハードは米国サーモグラフィーメーカーの開発者ブログにも載るお墨付きのものです。

今回のシステムの為に新たにサーモグラフィー機器とnvidiaの機器と有線、無線接続用ラズベリーPI 3B+とそのソフトウェアを開発。

*11月15日現在基本部分の90%は完成して調整中、サーモセンサーからPi3との有線接続の部分はほぼ一からの開発で調整にまだまだ時間がかかります。

JECA FAIRで無線LAN機器が多すぎて接続失敗したので有線LANを使えるようにソフトもハードも変更したのでそれに時間が掛かっています。思いの外、サーモセンサー挙動と新しい機器との調整に悪戦苦闘中。

また出来るだけキャッチーなデモの見せ方の検討中。

判定を各色LEDで表示は直ぐに出来ますが、見た目がショボい感じ。時間的に制約がありますが、Text to speechファンクションを使って判定結果を音声出力等々検討中。

PI3より小型のPI Zeroはサーモグラフィーの可視化の為の処理スピード不足で断念!

ソフトウェアの殆どはオープンソースで無料で尚且つ一部独自に開発した認識スピードアップのアドオンも無償で公開します。

それぞれの取り扱いやインストールする際の注意点等もブログに載せて説明。

(ある程度のソフトウェア、ハードウェアの知識は必要。その知識はAIや機械学習を事業と行う以上最低限必要なレベル。)

これらを使えば機械学習の教師付き学習データを独自にアノテーションして学習させてその推論を検証再学習が可能。その過程で機械学習のknow-howを蓄積、応用技術の開発また同じハードウェアでTenser flow、ChainerやPyTorchなど他のフレームワークへも柔軟に変更可能。

このサービスを共有する事で同じ中小企業で手軽に機械学習を始められその中で得られた知識でそれぞれの会社で応用可能な技術開発が低コスト可能になる。

当社としてはこのサービスを提供する事によりAIや機械学習技術をより多くの企業が実現可能になる手助けをする事でそれぞれの分野でこの技術を普及する事で社会の役立つと考えます。

また下記コンテスト要件も満たす事が出来る。

1)実現性 既存ビジネスと差別化できており、明確かつ現実的な内容である。

AIの導入をサポートするという視点でシステムを組んでいるので既存のハードやソフトを販売するビジネスモデルとは差別化できている。基本的な部分は実現出来ている。

2)収益性 将来的に収益の見込める内容であること。

当社はソフト的なサポートをするので、基本ユーザーのDIYなので共鳴する会社が増えても比例して収益が増える事はないが、それぞれの会社でAIや機械学習が実践、理解が進み発展する事で社会に貢献出来る。

3)ユーザー視点 ユーザーの価値創造が明確な内容であること。

そもそも自社用に開発したものなのでユーザー視点である事。それぞれのユーザーがこのサービスを利用する事でそれぞれの企業でAIや機械学習を使った付加価値の創造が可能。

4)社会性 社会課題の解決に向けた内容であること。

現在のAIや機械学習のミスマッチングを改善してこの技術の普及の助けになる事で社会に貢献出来る。

5)技術性 独創的な技術を取り入れた内容であること。

2018年の時点の最新のソフトとハードを取り入れました。

また様々な応用の効く独自に開発したサーモグラフィーを利用したシステムも併用出来る様にした。またその内容は殆ど公開予定。この点に関しては現時点で日本以外の国を含めて誰にも負けない自信あります。メーカーを含めて他社は単純なRGB画像出力に対して生データ(各ポイントの温度データ)をカラーパレットで8−9FPSで画像化しています。

オリジナルメーカーの開発者ページに掲載されているのもここがポイントです。iPhoneアプリのダウンロードは日本より北米で圧倒的に多く支持されています。日本の6倍以上!オーストライアだけでも日本の倍です。

これで3つの要件を満たしました。

①当社独自のAIと機械学習の開発

②大阪商工会議所 第二回AIコンテストの申し込み

③同じ様な問題を抱える会社と技術を共有する事での社会貢献

謝辞

この度このプロジェクトを進めるにあたり公私ともに小野武様には多大なご協力を頂きこの場をお借りして厚くお礼を申し上げます。

またこれらの機械学習フレームワーク、学習データソフトをオープンソースとして提供されている個人、団体へも畏敬の念を禁じ得ません。ありがたく使わせて頂きます。

2018年11月15日木曜日

AI pack

商工会議所のAIコンペ出場の準備中、素のマシーンに無線LANカード、やSSDの取り付けや調整は私には結構な手間が掛かります。何せLinuxマシンですから恐々作用をする羽目になります。

メインのGPUは黒いヒートシンクの中に隠れていて見えている基盤はキャリアボード(マザーボード)手前のコネクターが沢山ありますが並列演算結果を大量に遣り取りする為です。その上にNVMe250GBを取り付けてパーティションの設定中です。アノテーション(学習データ)や学習結果、その他の作業スペースを確保します。

今回東京や大阪のAIの情報取集していますが、大阪が50人規模に対して東京は200人規模で会場も盛況な印象。むしろ名古屋の方が多い(トヨタ関連や電子機器メーカーが多い為?)と主催者の話でした。大阪は集まらないって嘆いていました。

採用例の話で建築会社が建築途中の画像と図面に差異がないかを診断するAIを開発中との事で、無理無理AIを使おうとしている感じでした。下請けにきちんと予算を与えれば差異が生じる可能性が低くなると思ってしましました。大量生産工場の不良品の検出の事例とショップの顧客データを機械学習で解析して販売に生かすソフトなどがありました。

今回のコンペで入賞を目指しますが、個別にカスタマイズするよりAI自体のサービスを提供する工夫を考えた方が良い様に感じました。その為に打ち合わせています。例えばアノテーションの方法をマニュアル化してハードは顧客で調達設定、管理でソフトは無料、サポート有料が良いと思います。会社の売上を考えると?何ですが、直ぐにの中途半端な売上で問題対応する体制が整っていないのでそれでも共鳴する会社と一緒に問題解決する事を考えると必然的にそうなると思います。今後の可能性を検討すべきと思います。その理由はおいおい説明します。

2018年11月14日水曜日

共同開発者ご紹介します。Take's diary著者の小野さん

http://takesan.hatenablog.com/

社長と同じ年の未年のお方です。

このブログがきっかけでサーモグラフィーを一緒に作ってMakers fair Tokyo2017と2018に出展。その作品はFLIRアメリカの開発者ブログに載るほどの完成度。

C言語やLISPを自在に操るレベルですが定年前の現役時代は建築関係のお仕事。

但しその建築のお仕事の合間には読者投稿で記事になるレベル。この頃油の乗り切った30歳でこの時携わったお仕事はその後の東日本大震災に被災を受けてその際の対応で被害を最小限に留めたそうで、仕事でも畑の違う趣味でも大活躍。私も頑張らないと(汗)

平たくいうとスティーブ・ジョブズやビルゲイツと同じ時代。

知り合う前から機械学習を実践していてAI関係ブログの検索結果は常に上位にあり上場企業のドメインからのアクセスや海外からのアクセスも多数ある位のレベル。Makers fair Tokyo2018年に一緒に参加したデータサイエンティストの方もこのブログは有名との言わしめる程。

現在この分野は新しい研究結果が次々に出ているので一人で論文をこなすのはかなり大変で理論の理解より実践を第一優先。納得の行くものが出来るまでコンパイルを何百回もして粘り強いお仕事ぶり。この辺は昭和的ですが、だから貴重で、昨今のコピペのエンジニアには到底出来ないレベル。

社長と同じ年の未年のお方です。

このブログがきっかけでサーモグラフィーを一緒に作ってMakers fair Tokyo2017と2018に出展。その作品はFLIRアメリカの開発者ブログに載るほどの完成度。

C言語やLISPを自在に操るレベルですが定年前の現役時代は建築関係のお仕事。

但しその建築のお仕事の合間には読者投稿で記事になるレベル。この頃油の乗り切った30歳でこの時携わったお仕事はその後の東日本大震災に被災を受けてその際の対応で被害を最小限に留めたそうで、仕事でも畑の違う趣味でも大活躍。私も頑張らないと(汗)

ASCII1988年12月号

知り合う前から機械学習を実践していてAI関係ブログの検索結果は常に上位にあり上場企業のドメインからのアクセスや海外からのアクセスも多数ある位のレベル。Makers fair Tokyo2018年に一緒に参加したデータサイエンティストの方もこのブログは有名との言わしめる程。

現在この分野は新しい研究結果が次々に出ているので一人で論文をこなすのはかなり大変で理論の理解より実践を第一優先。納得の行くものが出来るまでコンパイルを何百回もして粘り強いお仕事ぶり。この辺は昭和的ですが、だから貴重で、昨今のコピペのエンジニアには到底出来ないレベル。

こんな人です。

2018年11月9日金曜日

AIビジネス創出アイデアコンテストサロン?

梅田の居酒屋で参加予定者6、7人と審査員3人と商工会議所職員二人と参加要件の確認。

どうもアイデアコンテストで実現性も採点の要素ではあるがデモは必須ではない様。

参加者と話をする限りこれからAIビジネスをコンテストを足がかりに始めるといった会社もあった。

医療系の画像診断を生業にしている年配の人も出席されていましたが、AIの技術的な理解に可也偏った印象。今までのセミナーと違いディープラーニングの技術的な理解をしている人はいない感じ。

2001年宇宙の旅みたいな事はあるかと聞く若い人もいたので戸惑います。

アイデアコンテストでビジネスを創出するにも現在可能な技術を理解無くしてアイデアを出しても具現化するところと組まなければただの空論です。

現在AIで事業をしている会社としようとしている会社では天と地ほどの能力に差があってこれが誤解を多くする諸悪の根源みたいです。

海外では出来る事を着実に積み重ねている現状に対して日本は一気にそこへ行こうとしてブラックボックスの上に乗っている印象

ある意味有意義な話が聞けました。

それを踏まえて準備します。

どうもアイデアコンテストで実現性も採点の要素ではあるがデモは必須ではない様。

参加者と話をする限りこれからAIビジネスをコンテストを足がかりに始めるといった会社もあった。

医療系の画像診断を生業にしている年配の人も出席されていましたが、AIの技術的な理解に可也偏った印象。今までのセミナーと違いディープラーニングの技術的な理解をしている人はいない感じ。

2001年宇宙の旅みたいな事はあるかと聞く若い人もいたので戸惑います。

アイデアコンテストでビジネスを創出するにも現在可能な技術を理解無くしてアイデアを出しても具現化するところと組まなければただの空論です。

現在AIで事業をしている会社としようとしている会社では天と地ほどの能力に差があってこれが誤解を多くする諸悪の根源みたいです。

海外では出来る事を着実に積み重ねている現状に対して日本は一気にそこへ行こうとしてブラックボックスの上に乗っている印象

ある意味有意義な話が聞けました。

それを踏まえて準備します。

2018年11月3日土曜日

いつものコーヒーショップで画像認識テスト

社長への簡単なプレゼンも終わり小さな内部メモリーから250GBのSSDにシステムや起動ファイルを移行も一段落。

画像認識の学習ファイルと学習データをSSDに写してからコンパイルのやり直し。

画像認識の学習ファイルと学習データをSSDに写してからコンパイルのやり直し。

cfgファイル書き直しとsrcファイルの再構成。Linuxのショートカットの作成方法がwindowsと違うので何度かやり直し。homeの絶対パスも結構ハマる。

so fileのパスも/home/nvidia/darknet/darknet.soへ

/home/nvidia/darknet/srcのリンクはln -s /home/nvidia/darknet/src src1

ln -s home/nvidia/darknet/src src1で嵌りました。

その後一旦コンパイルのやり直しの為make cleanしてmake -j8sしてから

make RunReleaseで無事にマイクロSDからSSDでビルド完了。

ここからは共同開発して頂いている小野さん待ち。赤外線画像認識をトリガーにしてPi Zero(IoT)を操作の予定。IoTエッジは変更の可能性あり、まだ10日程度掛かりそうです。無線LANのモデルが完成しているが過去繋がらないので有線の設定で作り直し。

途中ですがこんな感じ…

このAIコンペが終わったら社内で分かりやすく楽しいデモをするつもりです。お〜っとというものにするのに時間が掛かる。年末か年明けになると思います。その為の講習も12月3日東京で予約済み。

先ずはコンペに入賞して実績を作る事が最優先事項。

審査ポイント

1)実現性 既存ビジネスと差別化できており、明確かつ現実的な内容である。

AIの導入をサポートするという視点でシステムを組んでいるので既存のハードやソフトを販売するビジネスモデルとは差別化できている。

2)収益性 将来的に収益の見込める内容であること

導入の基本セットから収益を考えた価格設定。

3)ユーザー視点 ユーザーの価値創造が明確な内容であること

ユーザーそれぞれのAIや機械学習の理解に役立つサンプルになっている

4)社会性 社会課題の解決に向けた内容であること

日本のAIの理解は偏りがあり使いこなせる会社とそもそも理解できていない会社が混在しておりAIの技術的な理解なしに今後それぞれの課題の解決は難しいその理解の役に立つシステム。

5)技術性 独創的な技術を取り入れた内容であること

2018年の時点の最新のソフトとハードを取り入れ通常のカメラから独自に開発したサーモグラフィーを利用したシステムも併用出来る様にした。

2018年11月2日金曜日

AI(人工知能)ってなあ~に?ML(機械学習)?

今までの内容のおさらいです。

AI(人工知能)はメディア(テレビ、新聞や一部のネットニュース)で頻繁に登場しますが、業界ではAIという言葉を使わない様になっています。

理由はメディアが誤解を招く様な説明や、ある記事で単純作業の仕事がAIコンピューターに取られて失業率が上がるとか、AIに人が支配されるとか?(SFチック)に面白おかしく書き立てて勘違いする人が増えている為です。テレビのアナウンサーや記者がシステムを理解出来ていない。=殆どの人。その為テレビや新聞で曖昧な表現や注釈を入れずに説明すると誤解が生じています。

今のAIは全知全能のコンピューターを作ろうとしているのではありません。

業界ではそれらをML(機械学習)マシーンラーニングと呼んでいます。

①単純作業の内容を機械にさせて人間はもっと創造的な事をしようというものや、

②統計学的な膨大なデータからマーケットに必要な情報を抽出する様な事、

③発音や言語を理解してその答えを出す様な事、

④自動運転の車、機械を世界で開発しています。

他もありますがこの4つを発展応用したものです。

①では不良品の特徴を画像から学習させて学習結果から不良品をラインから取り除く。

②では風が吹けば桶屋が儲かるをデータから実証する。アマゾンの検索で買いたいものを入力すると他に買うだろう候補を順番に列挙する。

③それぞれの人々の発音の特徴量を学習して言葉を取り込み動作する。

”アレクサ!テレビでニュースをつけて!”とAIスピーカーに語り掛けるとテレビの適当なニュース番組を掛ける。

④道路標識、センターラインの情報を読み取って自動で車を走らせる、人やものが車の前に来ればもしくは来そうになれば停車する。他の自動車と協調して走行する。

等々

それぞれ必要な情報を学習して結果を出しているだけです。

今までとの違いは、何かの閾値を超えたら何かをするしないから、それぞれの条件から何をするのが最良かを数量で出力する。④で人が車の前に来てからブレーキを掛けていては遅いので前方の人がそのまま歩くと走行線上に来る確率が高ければ停車するといった事をしています。

要約すると膨大なデータから推論や推測を導く特徴量の計算をコンピュータでしているだけです。

人間の様な意思を持った知能がはたらいている訳ではありません。

ただその推論や推測は脳神経学の仕組みを計算式に組み入れています。

今回は結構乱暴なまとめですが文系の人の為の説明です。

AI(人工知能)はメディア(テレビ、新聞や一部のネットニュース)で頻繁に登場しますが、業界ではAIという言葉を使わない様になっています。

理由はメディアが誤解を招く様な説明や、ある記事で単純作業の仕事がAIコンピューターに取られて失業率が上がるとか、AIに人が支配されるとか?(SFチック)に面白おかしく書き立てて勘違いする人が増えている為です。テレビのアナウンサーや記者がシステムを理解出来ていない。=殆どの人。その為テレビや新聞で曖昧な表現や注釈を入れずに説明すると誤解が生じています。

今のAIは全知全能のコンピューターを作ろうとしているのではありません。

業界ではそれらをML(機械学習)マシーンラーニングと呼んでいます。

①単純作業の内容を機械にさせて人間はもっと創造的な事をしようというものや、

②統計学的な膨大なデータからマーケットに必要な情報を抽出する様な事、

③発音や言語を理解してその答えを出す様な事、

④自動運転の車、機械を世界で開発しています。

他もありますがこの4つを発展応用したものです。

①では不良品の特徴を画像から学習させて学習結果から不良品をラインから取り除く。

②では風が吹けば桶屋が儲かるをデータから実証する。アマゾンの検索で買いたいものを入力すると他に買うだろう候補を順番に列挙する。

③それぞれの人々の発音の特徴量を学習して言葉を取り込み動作する。

”アレクサ!テレビでニュースをつけて!”とAIスピーカーに語り掛けるとテレビの適当なニュース番組を掛ける。

④道路標識、センターラインの情報を読み取って自動で車を走らせる、人やものが車の前に来ればもしくは来そうになれば停車する。他の自動車と協調して走行する。

等々

それぞれ必要な情報を学習して結果を出しているだけです。

今までとの違いは、何かの閾値を超えたら何かをするしないから、それぞれの条件から何をするのが最良かを数量で出力する。④で人が車の前に来てからブレーキを掛けていては遅いので前方の人がそのまま歩くと走行線上に来る確率が高ければ停車するといった事をしています。

要約すると膨大なデータから推論や推測を導く特徴量の計算をコンピュータでしているだけです。

人間の様な意思を持った知能がはたらいている訳ではありません。

ただその推論や推測は脳神経学の仕組みを計算式に組み入れています。

今回は結構乱暴なまとめですが文系の人の為の説明です。

登録:

投稿 (Atom)